在Linux环境下,确保kafka消息顺序交付,需要采取多种策略协同工作。以下方法能有效提升消息顺序性:

分区策略:确保消息有序的关键

- 唯一分区键: 为每条消息分配一个唯一的键值(例如,订单ID或用户ID),确保具有相同键值的消息始终被发送到同一个分区。 这能保证同一分区内的消息按顺序处理。

消费者组配置:精细控制消费流程

- 单消费者模式: 每个消费者组仅包含一个消费者实例。这样,每个分区只由一个消费者处理,从而保证分区内消息的顺序性。

关键参数设置:优化生产者性能

- max.in.flight.requests.per.connection=1: 将此生产者配置参数设置为1,可以确保消息按照发送顺序写入Kafka服务器。

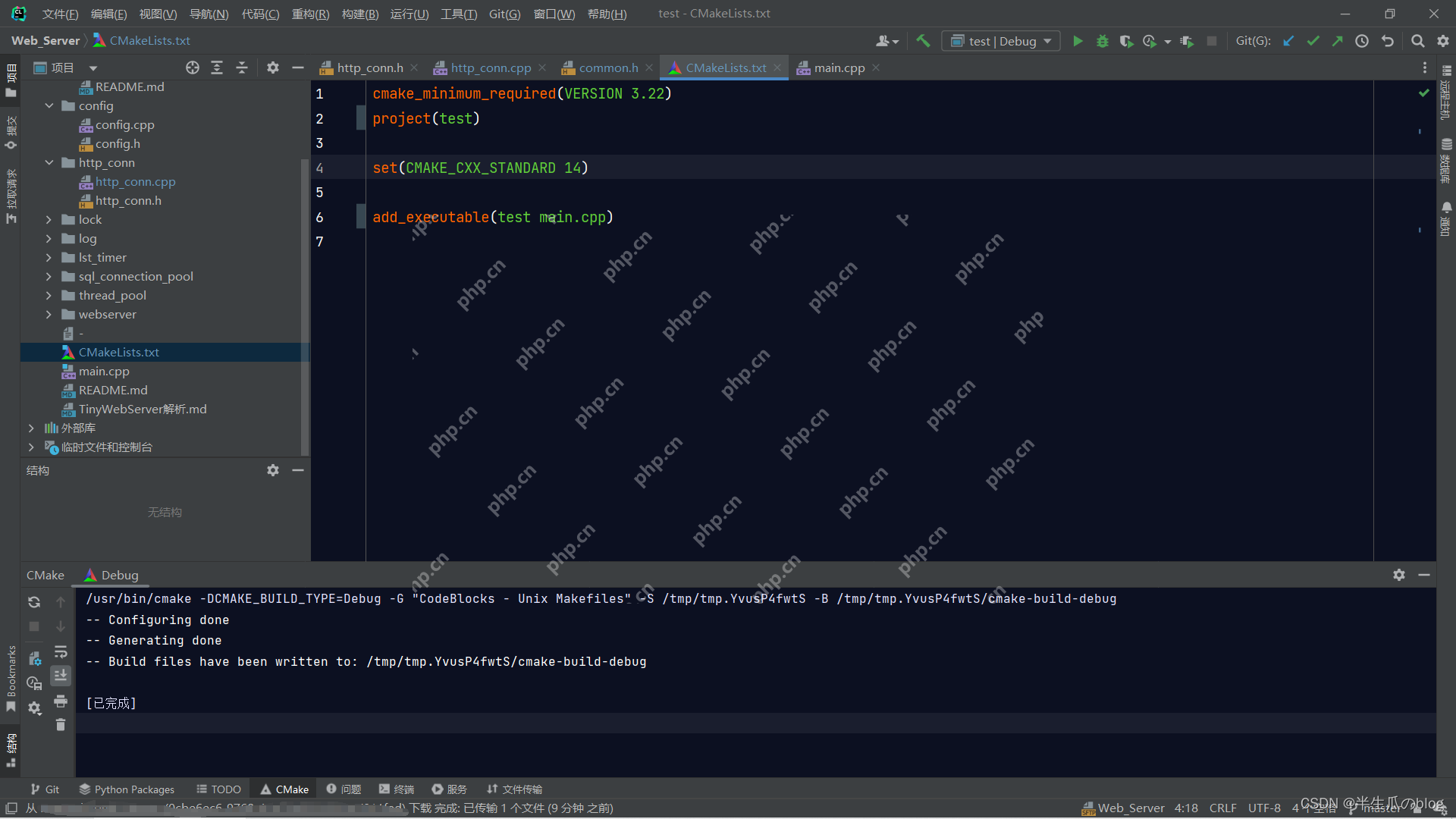

生产者与消费者代码示例 (Java)

以下代码片段展示了如何在Java中实现具有顺序性的Kafka生产者和消费者:

生产者示例:

Properties properties = new Properties(); properties.put(ProducerConfig.bootstrap_SERVERS_CONFIG, "localhost:9092"); properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName()); properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName()); try (KafkaProducer<String, String> producer = new KafkaProducer<>(properties)) { String topic = "my-ordered-topic"; String key = "order123"; // 唯一键 String message = "Order 123 processed"; ProducerRecord<String, String> record = new ProducerRecord<>(topic, key, message); producer.send(record); }

消费者示例:

Properties properties = new Properties(); properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092"); properties.put(ConsumerConfig.GROUP_ID_CONFIG, "my-single-consumer-group"); properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName()); properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName()); try (KafkaConsumer<String, String> consumer = new KafkaConsumer<>(properties)) { consumer.subscribe(Collections.singletonList("my-ordered-topic")); while (true) { ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100)); for (ConsumerRecord<String, String> record : records) { // 按顺序处理消息 processMessage(record.value()); } } }

重要提示

- 高吞吐量下的权衡: 单消费者模式在高吞吐量场景下可能成为性能瓶颈。 可以考虑多消费者,但每个消费者只处理一个分区。

- 全局顺序性: 如果需要整个Topic的消息都严格顺序,则只能使用单个分区。

通过合理运用以上策略和代码示例,可以有效地在Linux系统上保障Kafka消息的顺序性。 选择合适的策略取决于具体的应用场景和性能需求。